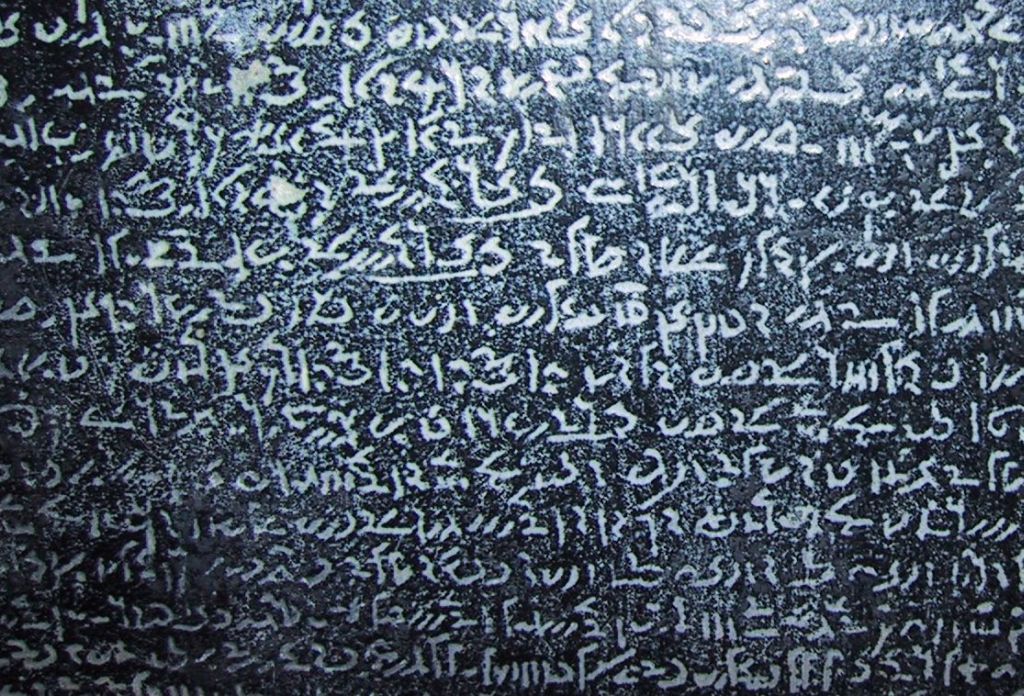

"DemoticScriptsRosettaStoneReplica" by Chris 73 / Wikimedia Commons. Licensed under CC BY-SA 3.0 via Wikimedia Commons.

I dag hade vi ett jätteintressant heldagsseminarium på jobbet om långsiktigt digitalt bevarande (LDB) av forskningsmaterial. Många, många intressanta frågor dök upp och diskussioner fördes. Vad gäller forskningsdata anser jag att de största utmaningarna är administrativa: vi behöver en struktur för att hantera bevarandeplanering etc för olika områden och en fungerande arbetsfördelning gällande olika processer i sammanhanget. Den andra stora utmaningen är att överhuvudtaget få forskarna att engagera sig i sin datahantering och tillmäta data tillräckliga resurser och tillräckligt värde. Får vi dessa två bitar på plats har vi kommit mycket långt. En viktig poäng är, tycker jag, att forskare själva inte behöver befatta sig med långsiktigt bevarande. Det ska ordnas av forskningsorganisationer, dataarkiv och staten. Inget extra arbete behövs av forskarna för den biten, bara vad som borde vara normalt förvaltande av forskningsinformation. Men där finns en del att göra, både var gäller kompetens och motivation.

En annan sak som lite relaterar till frågan är den om värdering och prioritering av data. LDB är dyrt och vi måste prioritera. Det borde göras av forskarsamfundet. Det talas mycket om mätare och altmetrik och det gör mig lite kallsvettig. Visst, att data laddats ner mycket tyder på att det har en viss betydelse (en hel data laddas t ex ner för undervisningssyften). Sådan data är troligen användbar. Men det säger nödvändigtvis inget alls om dess värde: om det kostat massor av pengar att producera, om det är helt unikt och oersättligt, fyller en viktigt nisch t ex i ett internationellt perspektiv eller om det kanske är just precis det dataset som laddas ner av en forskare som gör en upptäckt som räddar mänskligheten eller sparar samhället enorma resurser om tjugo år. Dessutom är det dumheter att man kunde jämföra olika typer av data: en viss typ av data kan generera tusentals "nedladdningar" på en gång, medan något jättelikt dataset kan se ut som ett enda. Och inte går det att räkna bittar heller. Kort sagt: SLUTA RÄKNA! Det är bortkastad energi att försöka dra större slutsatser på basis av citat eller annan statistik. Och ännu värre, det kan ge en skenbar känsla av objektivitet, som kan få direkt förödande följder.

Men det var inte det jag skulle skriva om heller, egentligen, utan jag ville tjata lite om vikten av länkad data och semantisk webb. Digital humaniora växer kraftigt och "genren" har länge dominerats av våra duktiga lingvister. Men i dag börjar också andra kultur- och samhällsforskare av olika slag vakna upp till den digitala teknologins möjligheter. Det innebär att vi behöver börja beakta vad saker betyder i högre grad än förr. Och det betyder kort sagt semantisk annotering, ontologier osv. (Vad detta innebär för LDB ids jag inte ens tänka på nu ...). Hur som helst måste vi börja tackla de svåra problemen med tolkning maskinellt. För det är redan på gång. I Finland har vi också varit duktiga på semantisk webb. Nu skulle det gälla att slå ihop dessa kompetenser på allvar. Länkning blir särskilt viktigt för humanister, eftersom våra data finns kors och tvärs i olika system.

Ett exempel från Kanada. Liknande saker kan vi också göra om vi vill,

och mer är förhoppningsvis på kommande. (Videon via @PekkaHenttonen)

Inga kommentarer:

Skicka en kommentar